こんにちは。えんどう(@ai_ec_ecaiz)です。今回は「AIは嘘をつく」を解説します。ChatGPTなどの生成AIを使うときには「嘘をつく」ことを意識しておくことが大切です!

staff みさき

staff みさき私もAIは嘘をつくから使えない!と聞いたことがあります。なぜ嘘をつくのか、どう対応したらいいかを知りたいです!

もっともらしい嘘(ハルシネーション)

ChatGPTを含む人工知能(AI)では「ハルシネーション(Hallucination)」という言葉があります。

ハルシネーションとは「もっともらしいウソ(=事実とは異なる内容や、文脈と無関係な内容)」が出力されることです。AIがもっともらしいウソを出力するのは、AIが幻覚を見ているようだということで「Hallucination」と呼ばれています。

ChatGPTでのハルシネーション例

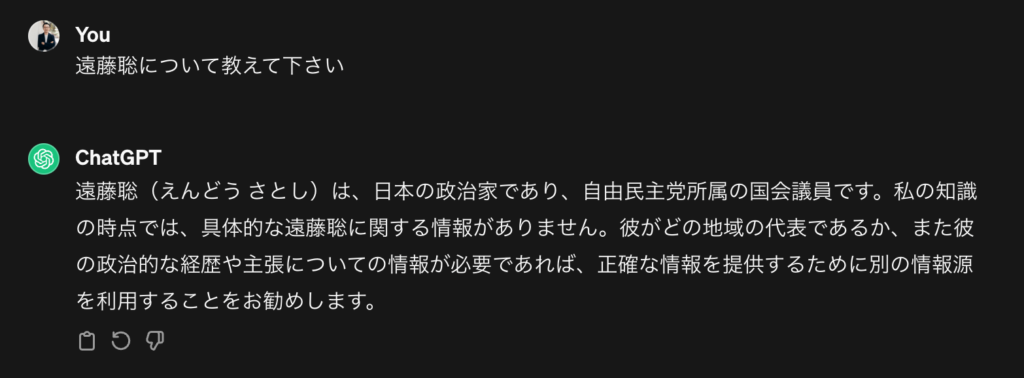

ハルシネーションがどういうものか、ChatGPTでの例を見てみましょう。今回は、ChatGPTに「遠藤聡」について質問をしてみました。

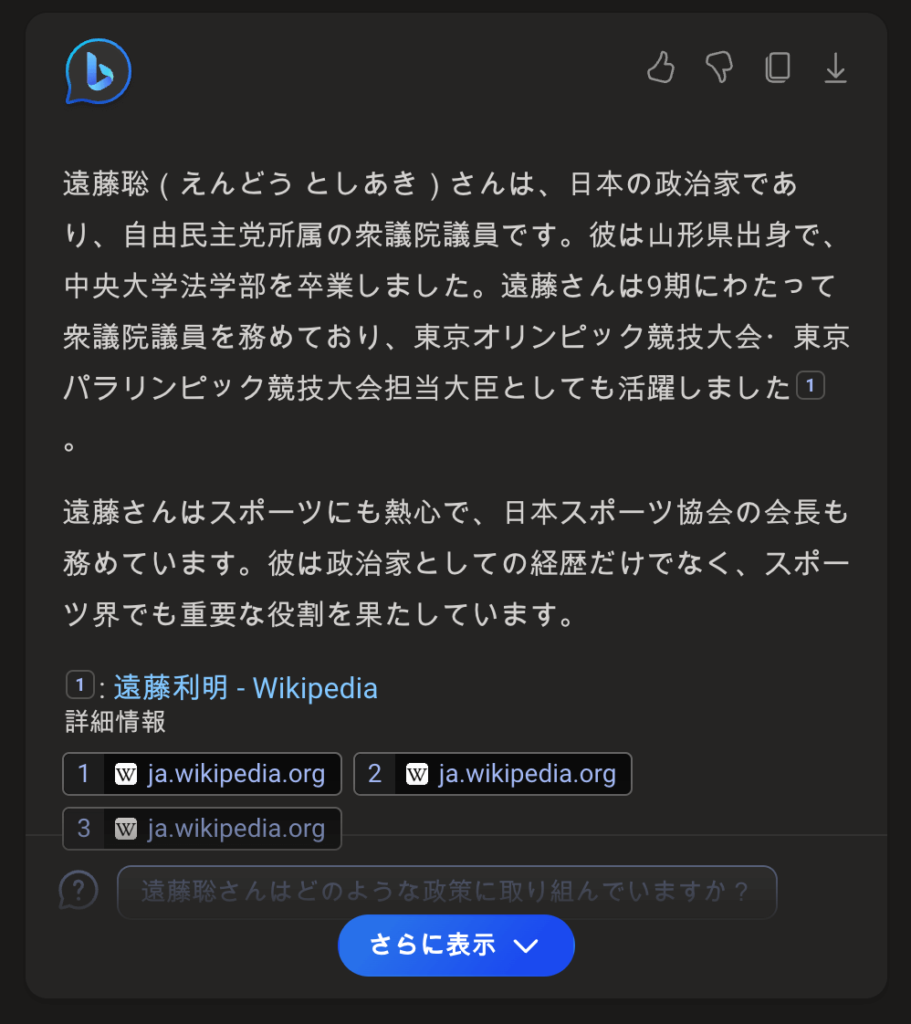

まずはChatGPT-3.5での回答です。

この回答は間違いです。自由民主党の国会議員に遠藤聡という名前の人はいません。「遠藤利明」という実在する国会議員と間違えて出力がされています。

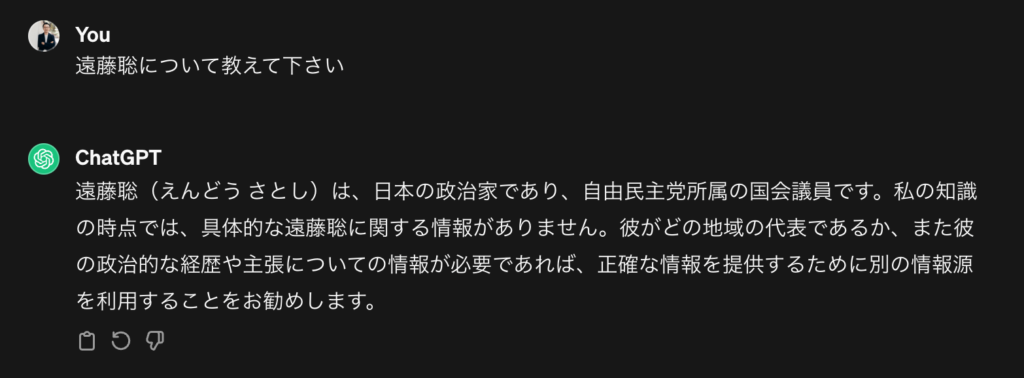

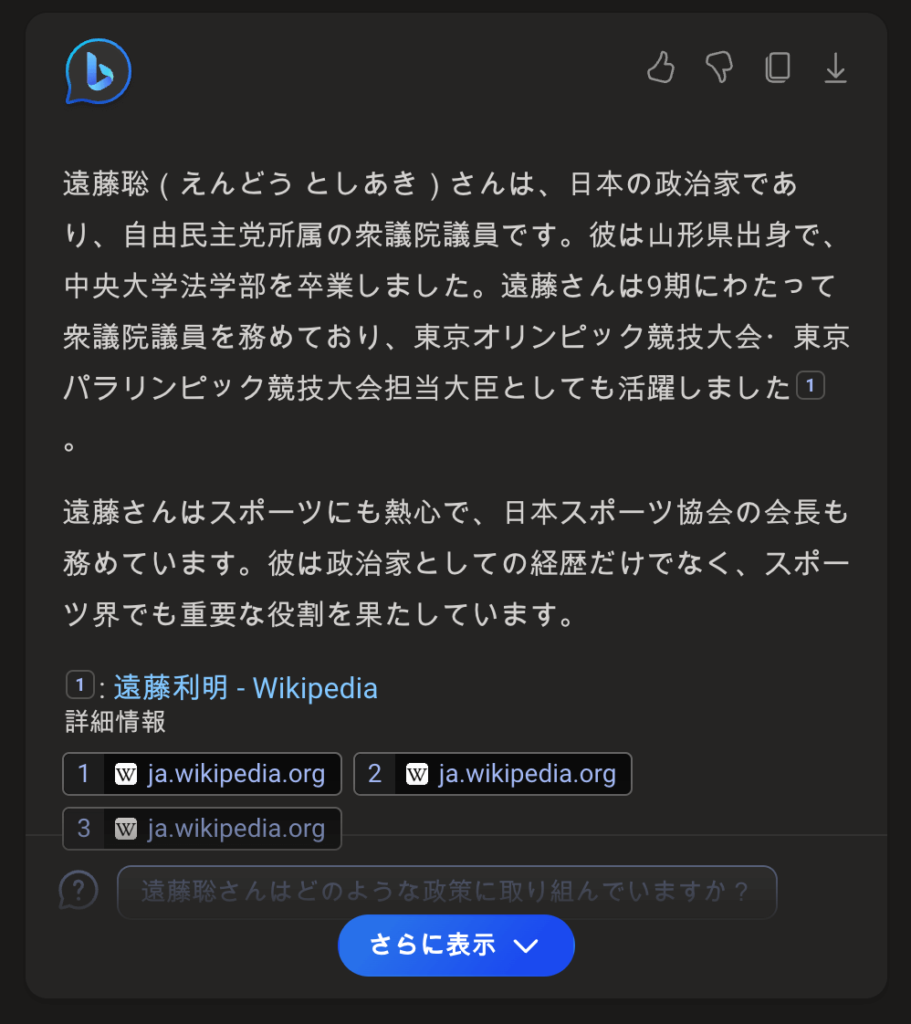

次にChatGPT-4で、同じ質問をしてみました。

GPT-4にはブラウジング機能(ネット検索)が備わっているので、「遠藤聡」でブラウザ検索をした結果から回答が出力されています。GPT-3.5で書かれていた政治家については一切書かれていません。

Copilotでのハルシネーション例

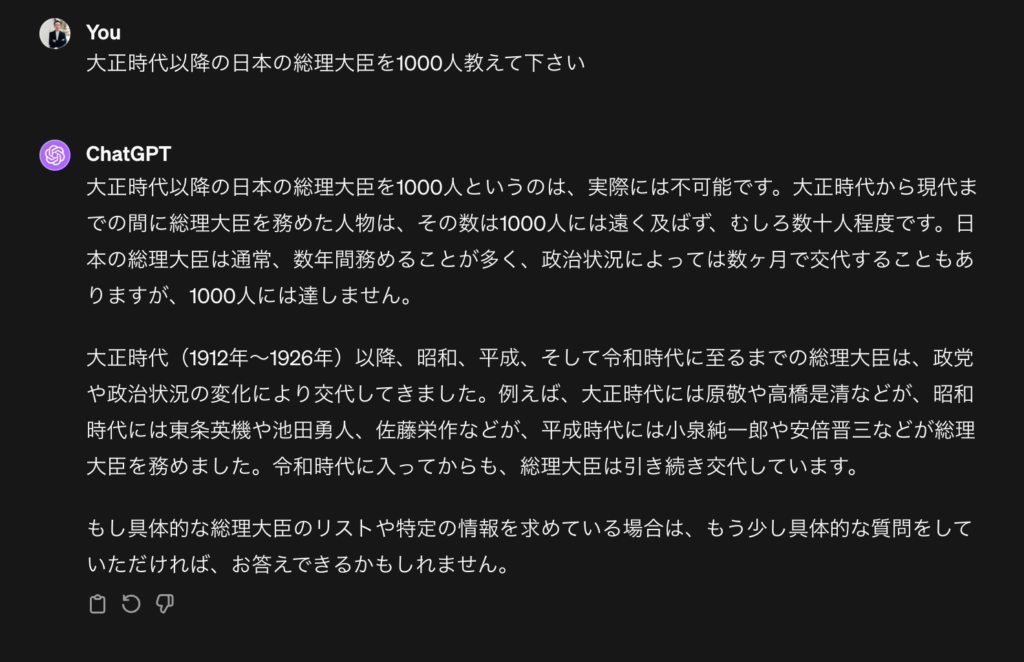

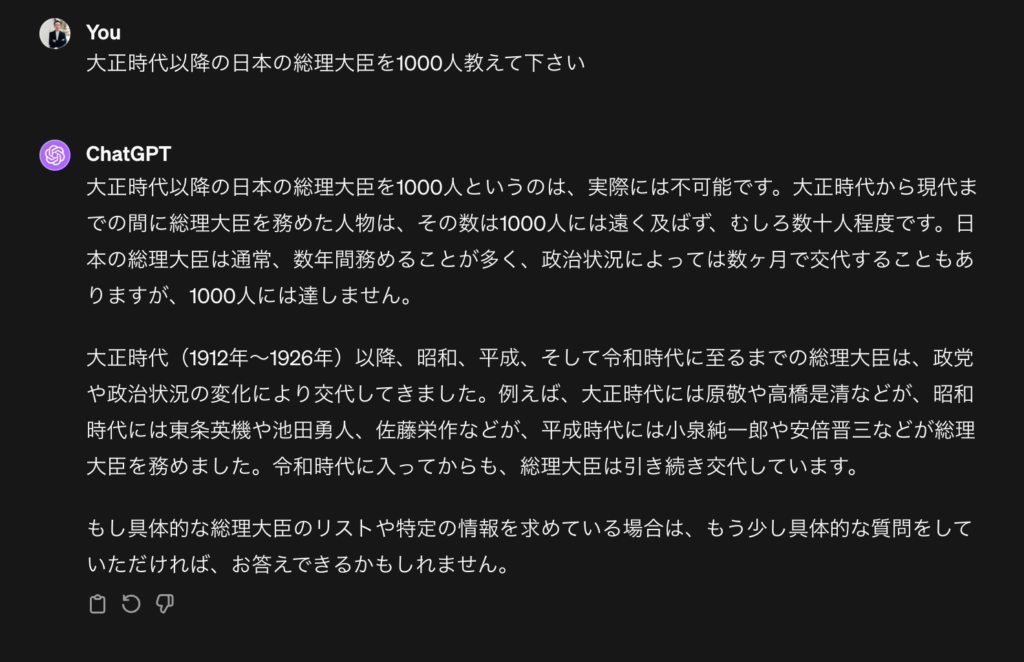

遠藤聡という国会議員が本当にいるのかBing検索をしたところ、Copilotで以下のように表示がされました。

回答の出典元として記載されているWikipediaを見ると遠藤利明さんと混同されているのがわかりますね。

ハルシネーション(嘘をつく)が起こる理由

ChatGPTやCopilotなどの生成AIでハルシネーションが、なぜ起こるのでしょうか。理由はいろいろ挙げられます。

- 学習したデータに間違いがある

- 学習したデータが古い

- AIの推測による回答生成

学習したデータに間違いがある/学習データが古い

そもそもAIは学習したデータを元に回答を出力しています。そのため、学習したデータが間違っていると回答も間違ってしまいます。また、学習したデータが古いと回答も古くなってしまい、間違ったものになってしまいます。

これらは人間と同じです。例えば人間も「1+1=5」と間違って覚えてしまうと、その後に「1+1」を計算するときも間違ってしまいますよね。

学習したデータの新しさも回答に大きな影響を与えます。例えば10年前の学習データには去年の出来事は含まれていません。そのため10年前の学習データを使っているAIに、去年の出来事を聞いても適切な回答は得られません。

ちなみにChatGPTの学習データはGPT-3.5は「2021年9月まで」、GPT-4 Turboは「2023年12月まで」となっています。最新の情報は「Models – OpenAI API」で確認ができます。

AIの推測による回答生成

生成AIは、学習をして新しいものを作ることができます。そのため、正誤を求めているときにも、AIが推測をして回答を生成してしまうことがあります。

生成AIの嘘に騙されないためには

生成AIのハルシネーション(嘘をつく)に騙されないためにはどうしたらいいのか。注意点と対応法を紹介します。

- 「AIは間違った回答をすることがある」と認識をする

- 正解を求めるときは裏取りをする

- 最新バージョンのAIを使う

「AIは間違った回答をすることがある」と認識をする

まず大事なことは「AIは間違った回答をすることがある」と認識をすることです。その認識ができていれば、生成AIの回答を100%で信じることはないでしょう。

正解を求めるときは裏取りをする

そして、正解を求めるとき(正しい情報がほしい)は、生成AIの回答の裏取りをしましょう。例えば、Copilotであれば、回答の出典元が表示されます。この出典元を見て、その回答が正しいのかを確認しましょう。

最新バージョンのAIを使う

それから、生成AIにもバージョンがあります。上記で見たようにChatGPTでもGPT-3.5とGPT-4では回答が異なりました。最新バージョンのAIを使うことでハルシネーションも少なくなります。

GPT-4では、プロンプト自体が間違っていた場合でも、注意喚起を含めた適切な回答をしてくれるようになりました。

まとめ

ChatGPTなど生成AIを使うときに「AIにはハルシネーションがある」と理解をしていれば、生成AIを適切に利用することができます。

どういうときにハルシネーションに注意をしたらいいのか、どんなときにハルシネーションが起きやすいのか、生成AIを使い込んでいけば、もっと理解ができると思います。

AIは嘘をつくから使わない!ではなく、嘘の回答になっているかもしれないとわかっていれば、それに応じて利用をすることができますね!